Cuando Berners-Lee volvió al CERN el uso de la propia red internet había cambiado: “el mundo había cambiado. La internet, aunque todavía desconocida para gran parte del público, estaba ahora firmemente arraigada. Era esencialmente una escueta infraestructura, un enrejado de tubos vacíos. Había formas de recuperar los datos, pero no existían maneras muy fáciles para llevarlo a cabo, y ciertamente, no había nada y nada con la estructura intuitiva y neuronal estructura del hipertexto” (Wright, 1997).

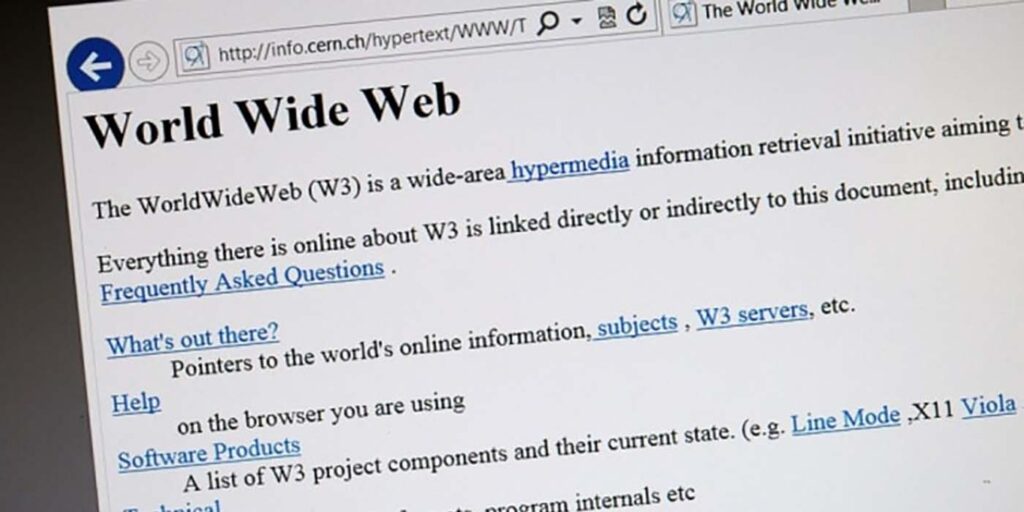

La propuesta de solución de hipertexto para la gestión de información prosperó. La misma conllevó la creación de la web. Para ello, Berners-Lee no se anduvo con medias tintas planteando propuestas teóricas pendientes de implantación posterior, todo lo contrario, buscó una solución a partir de nuevos desarrollos y adaptaciones de algunas aportaciones anteriores. Así, desarrolló el protocolo ligero de comunicaciones que permite llevar a cabo la navegación por la web – http – y desarrolló el lenguaje HTML de marcado que permite elaborar páginas. A estas dos propuestas unió las soluciones informáticas para el soporte (servidor web), para la navegación (cliente web o navegadore), y la edición de textos en HTML. Con ello se puso en marcha el sistema de información que todo lo revolucionó.

Siendo, sin duda alguna, la mayor creación tecnológica jamás desarrollada en nuestro campo desde la creación de internet, su importancia queda algo reducida si la comparamos con el resultado unos años después: un orbe infinito de información de acceso libre y universal (sin limitaciones en lo geográfico como en las posibles discapacidades personales o tecnológicas, al menos al principio, hasta que muchos intereses espúreos se hicieron presentes en la web).

Si alguna vez, Berners-Lee fue consciente de la grandiosidad de su invento sólo él lo sabe, y sólo a él, en justicia cabe preguntarle, los demás sólo podemos elucubrar al respecto. Lo que sí es cierto es el hecho irrefutable de que la web y sus tecnologías asociadas forman parte del modo de vida cotidiano de todos nosotros. De hecho, quienes han nacido este siglo (y en los últimos años del anterior), los llamados “nativos digitales”, no conciben la vida sin su existencia, especialmente desde la popularización del uso de aplicaciones como el correo electrónico outlook o los motores de búsqueda Google o Yahoo! (por citar algunas de las tecnologías más clásicas), o la mensajería por Whatsapp o el intercambio de fotos, opiniones y comentarios en la red de microblogging Twitter (ahora X).

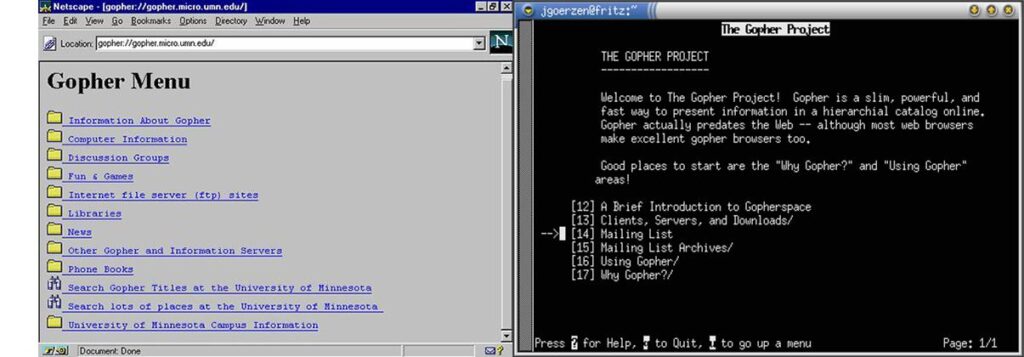

La implantación de la web fue meteórica. En pocos meses había ocupado el espacio que había ocupado Gopher, sistema de información en formato de tablero electrónico (parecido al teletexto de la televisión) muy popular entre las comunidades universitarias que permitió plasmar en la red dos ideas importantes: (1) la interconexión de servidores (a modo de enlace) y (2) la interoperabilidad con aplicaciones a las que se accedía por acceso remoto o telnet, como era el caso de los primeros módulos de consulta en línea de catálogos de bibliotecas (OPACs). Hacia 1995 existían en internet más de dos millones de servidores basados en esta tecnología que fueron rápidamente sustituidos por la web por la mejor experiencia de usuario y la multitud de ventajas aportadas por la web, convirtiendo el uso de esta aplicación en un recuerdo casi romántico en la mente de aquellos que la llegamos a manipular. Sobre Gopher se construyó la primera Hytelnet que interconectaba los catálogos de las bibliotecas (luego se implementó en la web).

Leonard Kleinrock, uno de los inventores de internet, comentó en una entrevista hace unos años que lo más le gustaba de su invento era el hecho de “haber estado allí«. A un nivel infinitamente menor de relevancia y desde la perspectiva de un humilde profesor, muchos profesores de Tecnologías de la Información y Documentación Automatizada en los estudios de Biblioteconomía y Documentación en España tenían que utilizar diapositivas o versiones de demostración para simular a los alumnos la recuperación de información online en bases de datos bibliográficas (Medline, ERIC o Lisa por ejemplo) porque no podíamos asumir los costes de la conexión telefónica. Conectar las universidades a internet de y la creación de la web acercó a los profesores y estudiantes a una industria de la información hasta entonces prácticamente inaccesible. Estos profesores y estudiantes pudieron, de una manera humilde obviamente, colaborar en el desarrollo de este nuevo entorno que además ayudó a aumentar el conocimiento de la tecnología que lo sustentaba. De hecho, la creación de la web coincidió con la mejora y liberalización del acceso a la internet en muchos lugares del mundo, por lo que en el imaginario colectivo de buena parte de los ciudadanos reside la idea de que la web trajo la internet a nuestra vida, algo que tiene algo de cierto, incluso puede ser que mucho pero que no es así del todo.

Y por una vez, que no la única afortunadamente (véase el tremendo empujón que los investigadores del mundo llevaron a cabo para diseñar vacunas contra la COVID-19), acompañando a profesores e investigadores en el descubrimiento de los posibles usos y aplicaciones de la web ahí estaban también los profesionales de la información, participando en su desarrollo, no dejándolo (como ocurre con otras tecnologías) en las manos exclusivas de los informáticos.

Y con ello comenzaron a publicarse las primeras páginas web – la mayoría con un diseño manifiestamente mejorable como la que hicimos en la Universidad de Murcia – y se comenzó a dar forma a los primeros sitios web para, poco a poco, conseguir la integración de la información con servicios y aplicaciones en el formato de portal web (López Carreño, 2004). Todo esto no fue flor de un día, sino que precisó de algunos años para su consolidación y desarrollo, período de tiempo que, obviamente, no resultó igualitario entre países y organizaciones. En esa primera etapa se trataba de una web de un sólo sentido: desde el editor (autor) al usuario (lector). Al principio no había retroalimentación ni interactividad alguna, algo que hoy en día parece imposible de concebir para muchos. En estos primigenios sitios web – la ahora llamada “Web 1.0” – solía incluirse una página con enlaces a un conjunto de otras páginas que el autor consideraba interesantes para sus lectores a modo de miscelánea. Esta acción no era otra cosa que la traslación del muy tradicional servicio de referencia que desde tiempos inmemoriales llevan a cabo los profesionales de la información en las bibliotecas y constituyó el germen para el desarrollo de los primeros sistemas de recuperación de información en la web: los índices o directorios, sistemas de los cuales Yahoo! fue durante un tiempo el mejor ejemplo. Los directorios, como todos recordarán son un producto documental considerado una fuente de información de carácter secundario porque dirige a la fuente original, justo lo que hacían y actualmente hacen estos sistemas de recuperación. Una actividad de gestión de información vuelve a confluir con la tecnología de la web.

El tremendo crecimiento de la edición y publicación de contenidos en la web, hizo muy pronto imposible la gestión manual de estos directorios que sólo alcanzaban a realizar una revisión muy superficial de lo publicado. Esto llevó al desarrollo de los motores de búsqueda, sistemas que alimentan sus bases de datos a partir de la ejecución de unos programas de rastreo (‘crawlers‘) que recopilan direcciones de páginas a partir de los enlaces insertos en las mismas y las indexan de forma automática llevando a cabo una revisión mucho más profunda de lo publicado y de los cambios producidos en los documentos ya recopilados anteriormente. Altavista, Lycos y AlltheWeb fueron algunos de estos sistemas y representaron una innovación de gran impacto en su momento, por primera vez se podía acceder a grandes cantidades de documentos con sólo introducir unas pocas palabras en la ecuación de búsqueda sin necesidad de tener apenas que estudiar el lenguaje de recuperación de información.