Durante la década de los años 80, además del tecno-pop, va cogiendo fuerza la idea de que el hipertexto puede ser la mejor solución para la gestión de la información porque la tecnología ya comenzaba a ofrecer soluciones para ello y porque cada vez se veía más claro que las bases de datos relacionales no se ajustaban bien del todo a las exigencias de unos sistemas de información cada vez más grandes y más multimedia. En aquella época es cuando surgen los primeros sistemas de hipertexto de uso más o menos corriente:

IBM BookMaster (1980s). Herramienta de autoría de documentos con capacidades de hipertexto y estructuración. Estaba concebida para crear manuales técnicos y documentación corporativa pero que introdujo ideas que posteriormente aparecieron en otras herramientas de hipertexto.

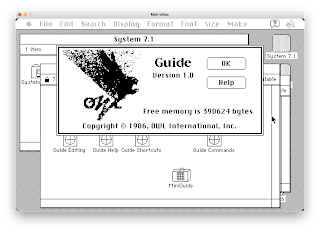

Guide (1982). Sistema desarrollado por Peter J. Brown en la Universidad de Kent y comercializado por Owl International, fue pionero en la navegación hipertextual estructurada. Se usaba para crear documentos extensos y complejos, como manuales técnicos y enciclopedias, en los que los usuarios exploraban la información por medio de enlaces integrados en el texto. Recuerdo de este sistema (llegué a usarlo a principio de los años 90) que introdujo el concepto de «expansión y contracción» del texto, en el que las secciones vinculadas se desplegaban o contraían dentro del mismo documento, ofreciendo una experiencia fluida sin necesidad de cambiar de pantalla (algo que no hace la web). Esta característica era especialmente útil para gestionar grandes cantidades de información de manera organizada y estos enlaces de expansión eran tremendamente útiles y sólo los vemos ahora en las barras de menús.

NoteCards (1984). Creado en el mítico Xerox PARC, fue otro sistema pionero que permitía gestionar ideas interconectadas con informaciones mediante «notas» que podían representar texto, imágenes o gráficos y estaban organizadas en «tarjetas» vinculadas por enlaces. Estaba programado en LISP (uno de los lenguajes de programación más emblemáticos en el campo de la IA creado por John McCarthy, uno de los padres de estas «inteligencias») y permitía a los autores usar comandos de este lenguaje para personalizar o crear tipos de nodos completamente nuevos (recuerda en algo las IA de gramática generativa, ¿verdad?).

HyperCard (1987). Fue la aplicación más conocida aunque solo funcionaba en los ordenadores Macintosh. Desarrollado por Bill Atkinson para Apple era una aplicación que combinaba características de bases de datos, programación y diseño multimedia. Así, permitía crear «pilas» de tarjetas interconectadas. En estas tarjetas podía haber texto, imágenes y botones interactivos que conducían a otras tarjetas, creando así una experiencia de navegación hipertextual. Si bien no pudimos usarlo en nuestra entonces pequeña escuela universitaria (no había presupuesto para adquirir un ordenador de la empresa de la «manzanita»), sí tuve ocasión de leer un manual del sistema. El mismo destacaba enormemente por su facilidad de uso y, además, incluía el lenguaje de programación HyperTalk que permitía a usuarios sin experiencia técnica crear aplicaciones personalizadas. Esta flexibilidad lo convirtió en una herramienta popular para la enseñanza, el desarrollo de juegos y la creación de aplicaciones interactivas. Influyó en el diseño de interfaces gráficas y en la concepción de la web al popularizar los enlaces que conectan diferentes piezas de información.

La disponibilidad de una tecnología capaz de gestionar la información de forma gráfica y, especialmente, que propiciase una lectura de forma no estrictamente secuencial, «cierra el ciclo» y termina «conectando» en el tiempo de Vannevar Bush y Ted H. Nelson con Tim Berners-Lee, joven (entonces) investigador británico que trabajaba en el CERN a principios de los 90 y quien asistía incrédulo a principios de esta década a la paradoja de comprobar día a día cómo en este laboratorio (un lugar donde todos los días se llevan a cabo pequeños milagros”, escucha el imaginario historiador Robert Langdon de boca de un también imaginario director del CERN en la novela “Ángeles y demonios” de Dan Brown), perdía información o tenía problemas para localizar proyectos desarrollados por científicos de muy alto nivel tras costosísimas horas de trabajo.

A Berners-Lee le desesperaba que esa “maravillosa organización” adoleciera de este problema, especialmente cuando en ella trabajaban miles de personas de alta cualificación intelectual, muy creativas la mayoría. Si bien estaban organizados en una estructura jerárquica, esto no limitaba la manera en la que se comunicaba y compartía información, equipo y software en todos los grupos. En realidad, más que de una jerarquía, la estructura de trabajo real del CERN era una red conectada que, además, aumentaba su tamaño con el paso del tiempo.

En este entorno, una persona que se incorporase a este laboratorio, como mucho recibía alguna pista sobre quiénes serían contactos útiles para recabar información verbal de lo disponible acerca de su proyecto y poco más: el resto consistía en un proceso de autoaprendizaje. Por entonces, no se tomaba esto como un problema porque las investigaciones del CERN alcanzaban un éxito notable (y alcanzan hoy en día), a pesar de los malentendidos ocasionales y de la duplicación de esfuerzos en la transmisión interna del conocimiento, sin olvidar las pérdidas de información (los detalles técnicos de proyectos anteriores a veces se perdían para siempre o sólo se recuperaban tras llevar a cabo una investigación típica de detective en una emergencia). El problema se agrandaba por la alta rotación de este personal investigador (muchos investigadores solo llegan a dos años de estancias en este centro).

También detectó otro problema que había pasado desapercibido: el modo de registrar la documentación de un proyecto. Si un experimento analizaba un fenómeno estático y particular, toda la información se podía registrar en un libro para posteriores consultas, pero esto no era lo frecuente. Cuando había que introducir un cambio en un proyecto que afectaba a una pequeña parte de la organización (cambiar una parte del experimento o comprar un nuevo detector de señales), el investigador debía averiguar qué otras partes de la organización y otros proyectos se iban a ver afectados. Con el tipo de libro de registro utilizado era prácticamente imposible de mantener actualizado y no ofrecía respuestas a cuestiones

Con el paso del tiempo esto se hubiera hecho insostenible. Era un problema a resolver en ese momento que no podía ser visto como un hecho aislado. La supervivencia de una organización de investigación está íntegramente ligada a su capacidad de mejorar su gestión de información. Para hacerla posible, el método de almacenamiento no debería imponer restricciones a la información. Una «red» de notas con enlaces (referencias) entre los documentos era una solución mucho más útil que un sistema jerárquico fijo (tipo carpetas de un administrador de ficheros).

Para describir un sistema complejo, muchas personas recurren a diagramas con círculos y flechas, esto permite describir relaciones entre los objetos de una manera que las tablas o directorios no pueden. Si llamamos a los círculos “nodos” y “enlaces” a las flechas e imaginamos cada nodo como una pequeña nota o pieza de información (da igual que sea un artículo, un resumen o una foto), se puede construir un sistema vinculado de información entre personas y piezas informativas en constante evolución. Así, la información de un proyecto no residirá sólo en una carpeta de documentos que difícilmente un nuevo investigador iba a reutilizar, ahora formaría parte de la red informativa organizacional en la que se establecerían vínculos entre otras personas y departamentos, garantizando la supervivencia de la información. Esta propuesta de sistema de almacenamiento iba va a conseguir implantar, al fin, la idea del hipertexto como sistema de gestión de información.

Lo verdaderamente curioso, algo que poca gente conoce, es que cuando Berners-Lee presentó su memorándun ‘Information Management: a proposal‘, su jefe de equipo le dio permiso para hacerlo «cuando no tuviera algo más importante que hacer«.

Menos mal que era gente «creativa«.

Fuente recomendada: Berners-Lee. T. (1989-1990). Information Management: a proposal.